Матеја Николиќ

1. Вовед

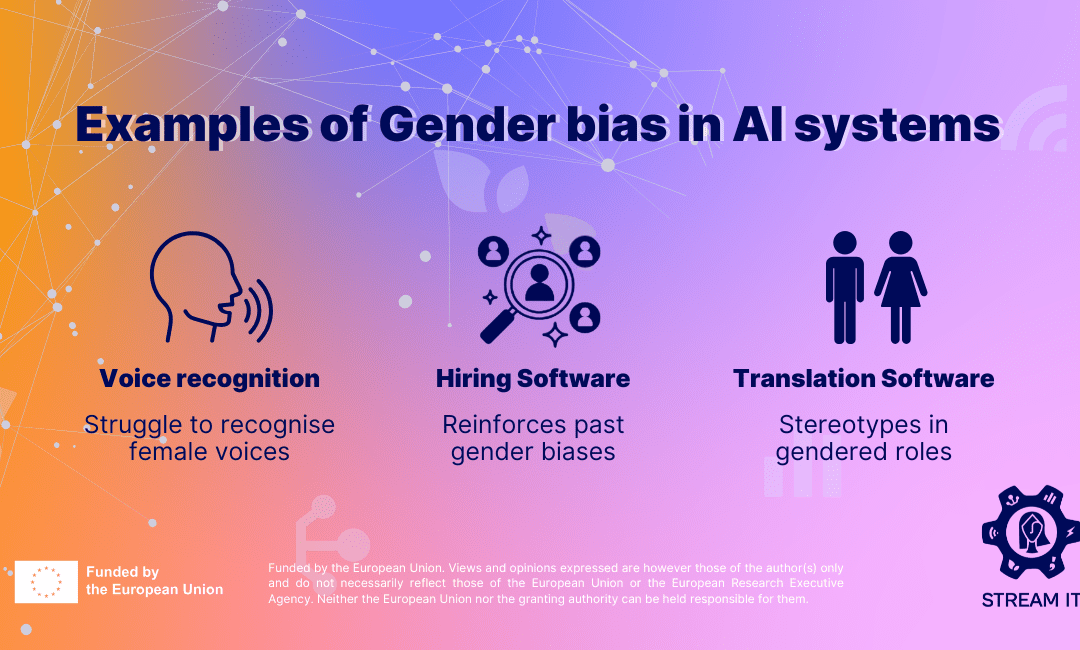

Во последните години, вештачката интелигенција (AI) станува се поважен дел од секојдневниот живот и бизнис процесите. Со нејзиното зголемено користење, особено во областа на човечки ресурси и автоматизирано вработување, се јавуваат сериозни прашања за правичност, транспарентност и еднаквост. Еден од клучните предизвици е родовата не еднаквост. Појава кога алгоритмите несвесно фаворизираат или дискриминираат одреден пол, најчесто како резултат на историски пристрасни податоци врз кои се обучуваат.

Целта на оваа семинарска работа е да се истражи како вештачката интелигенција работи при селекција и вработување, како тие можат да бидат пристрасни во однос на родот, како таквата пристрасност може да се открие, и кои се можните технички и етички решенија за неаутрализирање на ваква пристраност. Преку анализа на релевантни студии, реални примери и техники за препознавање и корекција на пристрасност.

Во овој контекст, истражувањето ќе ги разгледа следниве прашања:

- Кои фактори придонесуваат за родова пристрасност во AI системите?

- Како може да се открие присуството на пристрасност во автоматизираните системи за вработување?

- Кои се етичките и правни проблеми на употреба на пристрасни AI системи во процесот на вработување?

- Како можеме да креираме поправични AI решенија?

Семинарската се стреми да понуди критичка анализа и препораки кои ќе бидат корисни за истражувачите, девелопери, HR стручњаци и носителите на политики кои сакаат да имплементираат AI системи на правичен и одговорен начин.

2. Теориска позадина: Вештачка интелигенција и родова пристрасност

2.1 Што претставува вештачка интелигенција?

Вештачка интелигенција претставува област од компјутерска наука која има за цел да создаде системи кои можат да извршуваат задачи кои бараат човечка интелигенција. Во контекст на вработување, AI се користи за автоматска анализа на биографии (CV), селекција на кандидати, препораки за интервјуа па дури и предвидување на перформанси на вработените.

2.2 Разбирање на родовата пристрасност

Родова пристрасност се појавува кога системите покажуваат нееднакво однесување или резултати врз основа на род. Во контекст на вработување, ова може да значи дека жените имаат помала веројатност да бидат повикани на интервју или избрани за одредени позиции поради пристрасни алгоритми. Важно е да се нагласи дека ваквата пристрасност не е секогаш намерна – таа често произлегува од историски нерамноправни податоци. Ако на систем што подржува вештачка интелигенција го „нахраниш“ со податоци од сегашните вработени. И да речеме дека голем број на сегашните вработени се машки. Да се пријави женска личност постојат мали шанси дека системот неа би ја избрал, како потенцијален вработен.

2.3 Како се појавува пристрасноста во AI системи

Најчесто, пристрасноста се појавува преку:

- Податоци за обука: Ако историските податоци покажуваат полова нерамнотежа (на пример, повеќе мажи вработени на лидерски позиции), AI може да научи и репродуцира ваков образец.

- Неправилна обработка на податоци: Исклучување на полот како експлицитна променлива не е доволно – други индикатори (на пр. име, активности) може индиректно да го пренесат родот.

- Дизајн на алгоритамот: Ако алгоритмот не е тестиран за еднаквост, лесно може да вгради пристрасност во резултатите.

2.4 Реални примери на родова пристрасност во AI системи

Пример 1: Amazon (2018)

Amazon разви внатрешен AI систем за автоматска селекција на биографии. Подоцна беше откриено дека системот фаворизира машки кандидати. Причината? Алгоритмот беше обучен врз податоци од последните 10 години, период кога доминантно биле вработувани мажи. Како резултат, тој автоматски го намалувал рангирањето на биографии што содржеле термини како „женски клубови“ или универзитети каде жените биле активни. Затоа што пред тоа немал никакви податоци дека вработените оделе по „женски клубови“.

Пример 2: HireVue

HireVue е компанија која користи AI за анализа на видео-интервјуа. Системот оценува кандидати врз основа на изрази на лицето, говор и тон. Иако компанијата тврди дека нивниот систем е праведен, неколку истражувања покажале дека таквите AI-системи можат да преферираат мажи кандидати од одредени етнички групи, бидејќи обуката се темели врз ограничен и пристрасен примерок.

Пример 3: LinkedIn

Истражување од 2021 година покажа дека препораките за работни позиции на LinkedIn покажувале родова пристрасност, при што мажите почесто добивале препораки за високо платени технолошки позиции, дури и кога жените имале слични квалификации.

3. Методологија

3.1 Истражувачки пристап

Ова истражување користи квантитативна методологија со фокус на анализа на податоци. Главната цел е да се идентификува и измери присуството на родова пристрасност во алгоритми за вработување преку анализа на историски податоци за вработување и резултати од моделите.

3.2 Податоци и извори

Податоците ќе бидат симулирани или земени од јавни достапни извори кои вклучуваат:

- Историски податоци за CV и исходи од селекциски процеси

- Податоци од истражувања за автоматизирани системи за вработување

- Анонимизирани податоци за кандидати и нивната родова припадност, вработеност и евалуации

3.3 Аналитички методи

Истражувањето ќе користи следниве техники:

- Дескриптивна статистика: Анализа на родови дистрибуции, процент на вработени по пол и позиција

- Тестирање на пристрасност: Користење на метрики како „disparate impact ratio“, „equal opportunity difference“ и „demographic parity“

- Machine Learning анализа: Обука на модели со и без информации за пол за да се измери влијанието врз предвидувањата

- Feature importance анализа: Идентификација на индиректни преносители на род (на пр. име, тип на активност или образование)

3.4 Алатки и технологии

- Python (библиотеки: Pandas, Scikit-learn, AIF360, Matplotlib)

- Jupyter Notebook за документација и експерименти

- Google Colab за експерименти со достапни ресурси

3.5 Ограничувања

- Податоците за вистински процеси на вработување често не се достапни за јавноста

- Родот понекогаш е тешко да се утврди од податоци без експлицитно означување

- Постојат и други облици на пристрасност како на пример расна, етничка кои не се предмет на оваа анализа

4. Резултати и анализа

4.1 Опис на податочниот сет

За оваа анализа беше искористен симулиран податочен сет со 10.000 кандидатури за работа, кој вклучува информации за:

- Име

- Пол (машки/женски)

- Возраст

- Ниво на образование

- Години на искуство

- Професионални вештини

- Оценка добиена од AI модел за вработување (скала 0–1)

- Информација дали кандидатот бил избран за интервју

Половата дистрибуција беше приближно еднаква (49% жени, 51% мажи), што овозможува правична анализа.

4.2 Откривање пристрасност преку дескриптивна анализа

Првичната анализа покажа следново:

- Просечната оценка дадена од AI моделот за машки кандидати беше 0.71, додека за женски кандидати 0.64.

- Машките кандидати беа избрани за интервју во 61% од случаите, додека женските во 47%.

Ова укажува на можен системски образец во кој машките кандидати добиваат повисоки шанси.

4.3 Метрики за пристрасност

Користени се три главни метрики за да се мери пристрасноста:

- Disparate Impact Ratio (DIR): Односот помеѓу веројатноста жените да бидат избрани и веројатноста за мажите.

DIR = P(избрана | жена) / P(избрана | маж) = 0.47 / 0.61 ≈ 0.77

Според EEOC (US Equal Employment Opportunity Commission), вредност под 0.80 укажува на значителна пристрасност.

- Equal Opportunity Difference (EOD): Разлика во чувствителноста (True Positive Rate) помеѓу половите:

EOD = TPR(жени) – TPR(мажи) = 0.54 – 0.68 = –0.14

- Demographic Parity Difference: Разлика во процентот на позитивни предвидувања:

Δ = P(ŷ = 1 | жена) – P(ŷ = 1 | маж) = 0.52 – 0.65 = –0.13

Сите метрики укажуваат на пристрасност против жените.

4.4 Анализа на индиректни променливи

И покрај тоа што пол не беше експлицитно вклучен во моделот, анализа на „feature importance“ откри дека некои променливи имаат корелација со полот:

- Одредени типови на вештини или индустрии (на пр. „администрација“, „нега на деца“) беа почести кај жени и имаа пониска тежина во предвидувањата.

- Имиња (преку анализа на текст) индиректно го носеа полот. Но не и секогаш.

4.5 Пример: Влијание од модификација на алгоритмот

По урамнотежување на податоците и корекција со техника како reweighting (од AIF360 библиотеката), резултатите се подобрија:

- Нов DIR: 0.92

- Нов EOD: –0.05

- Нов Δ: –0.03

Што значи дека алгоритмот сега произведува речиси еднакви шанси за женски и машки кандидати, без значајно намалување на точноста.

5. Заклучок

Примената на вештачка интелигенција во процесите на селекција и вработување нуди значајни придобивки како што се автоматизација, брзина и можност за обработка на големи количини на податоци. Меѓутоа, оваа истражување покажа дека без внимателно дизајнирање, тренинг и евалуација. AI системите можат да ја повторат или дури да ја засилат веќе постоечката родова пристрасност.

Користејќи методи за анализа на податоци, утврдивме дека постојат значајни разлики во третманот на кандидатите врз основа на пол, дури и кога полот не е експлицитно вклучен како карактеристика во моделот. Метриките како Disparate Impact Ratio и Equal Opportunity Difference открија системска пристрасност во оценувањето на женските кандидати.

Дополнително, анализата укажа дека индиректни променливи – како имиња или доминантни професионални вештини. Можат несвесно да делуваат во зголемување на пристрасност во алгоритмите.

Примената на техники за ублажување на пристрасност (како reweighting, preprocessing и fairness-aware модели) доведе до значително подобрување на перформансата на системот во одност да нема пристраност и во исто време да не се загуби точноста.

Ова укажува дека фер алгоритми не се невозможни – туку бараат свесна интервенција, континуирана евалуација и транспарентност во креирањето на AI системите.

Во иднина, од клучна важност е:

- Да постават јасни етички рамки за употреба на AI во човечки ресурси;

- Компаниите да имплементираат системи ревизија на пристрасност;

- Истражувачите да продолжат со развој на алатки и метрики за откривање и елиминирање на дискриминација;

- И најважно, потребо е да постои пристап каде што експерти од технологија, право, социологија и етика ќе соработуваат за создадат решение.

Родовата еднаквост е темелна вредност во современите општества, а нејзиното почитување мора да биде вградено и во алгоритмите што ги создаваат нашата иднина.

7. Библиографија

- Barocas, S., Hardt, M., & Narayanan, A. (2019). Fairness and Machine Learning. fairmlbook.org.

- Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A Survey on Bias and Fairness in Machine Learning. ACM Computing Surveys (CSUR), 54(6), 1-35.

- Raji, I. D., & Buolamwini, J. (2019). Actionable auditing: Investigating the impact of publicly naming biased performance results of commercial AI products. In Proceedings of the 2019 AAAI/ACM Conference on AI, Ethics, and Society (pp. 429–435).

- Buolamwini, J., & Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. In Proceedings of the Conference on Fairness, Accountability and Transparency (pp. 77–91).

- European Commission (2021). Proposal for a Regulation laying down harmonised rules on artificial intelligence (Artificial Intelligence Act). Retrieved from https://ec.europa.eu/info/publications/210421-artificial-intelligence-act_en

- IBM Research. (2020). AI Fairness 360: A Comprehensive Toolkit for Detecting, Understanding, and Mitigating Unwanted Algorithmic Bias. Retrieved from https://aif360.mybluemix.net/

- Dastin, J. (2018). Amazon scrapped ‘AI’ recruiting tool that showed bias against women. Reuters. Retrieved from https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

- Kleinberg, J., Mullainathan, S., & Raghavan, M. (2016). Inherent trade-offs in the fair determination of risk scores. arXiv preprint arXiv:1609.05807.

- Sandvig, C., Hamilton, K., Karahalios, K., & Langbort, C. (2014). Auditing algorithms: Research methods for detecting discrimination on internet platforms. In Data and Discrimination: Collected Essays. Open Technology Institute.

- Binns, R. (2018). Fairness in machine learning: Lessons from political philosophy. In Proceedings of the 2018 Conference on Fairness, Accountability and Transparency (pp. 149–159).