Авторка Елена Иваноска

Како АИ ги одразува и засилува социјалните и родови неправди

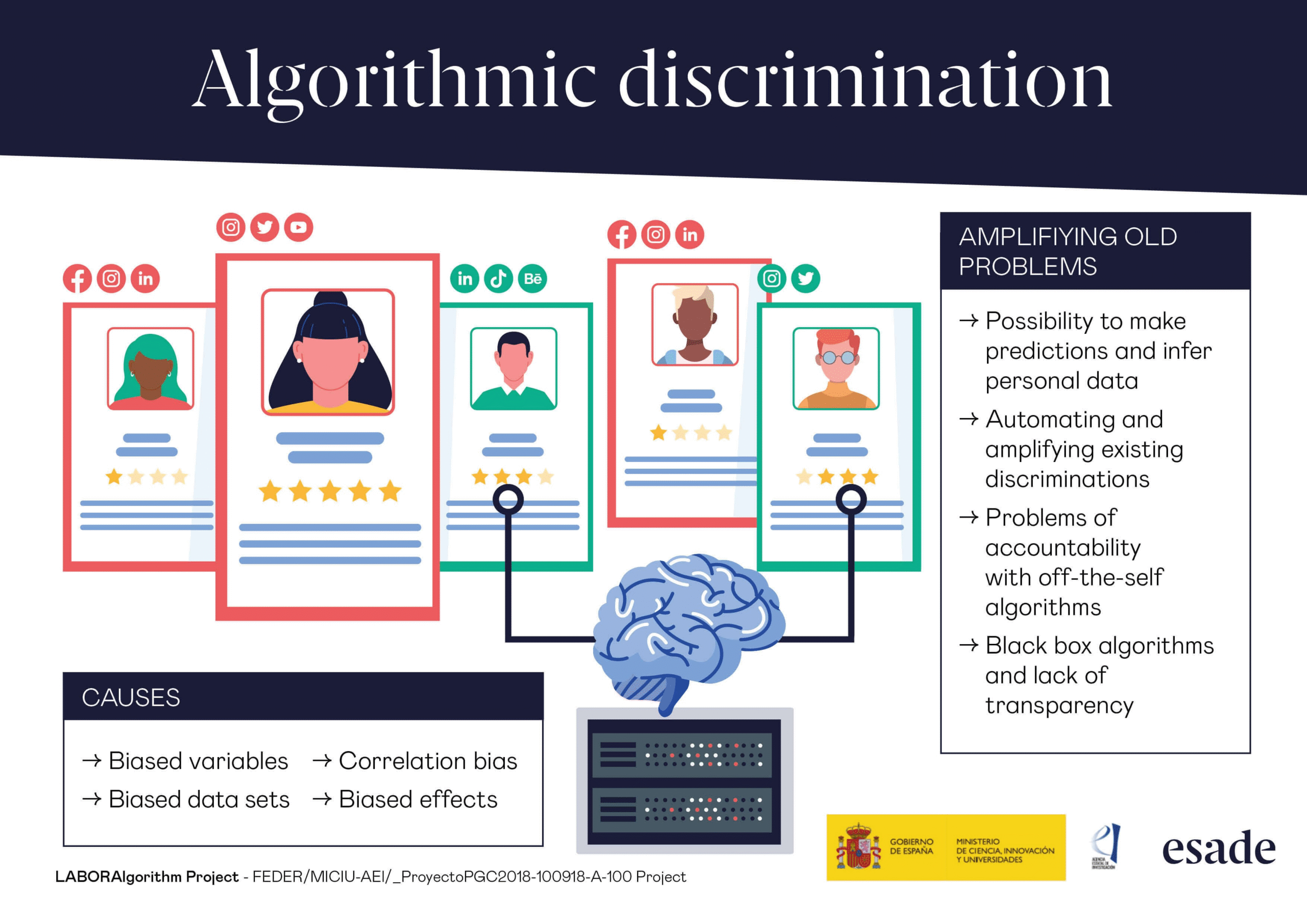

Во современото општество, вештачката интелигенција (АИ) станува клучна технологија што влијае врз сите аспекти на животот – од здравството и образованието до пазарот на трудот и правосудството. Нејзината брза експанзија го поставува прашањето за тоа како алгоритмите ја одразуваат реалноста – а со тоа и постојните социјални, економски и родови неправди. Наместо да претставува алатка за правна трансформација, АИ често репродуцира пристрасности што веќе постојат во податоците. Терминот „алгоритамска пристрасност“ се однесува на ситуации каде алгоритми донесуваат одлуки кои системски ги фаворизираат или дискриминираат одредени групи – врз основа на пол, раса, етничка припадност или социоекономски статус. Иако често се претпоставува дека технологијата е неутрална, податоците што се користат за тренирање на алгоритмите доаѓаат од општества кои самите се далеку од праведни. Оттука, кога се користат историски податоци за вработување, здравствени дијагнози или криминал, алгоритмите го „научуваат“ истото дискримнирано однесување. Amazon, Google, Facebook и други технолошки гиганти биле под лупа поради случаи на родова дискриминација во нивните АИ системи. За пример ќе го вклучам системот на Amazon за автоматизирано селектирање кандидати за работа, кој автоматски ги отфрлал апликациите што содржеле женски зборови или искуства, како „women’s college“ или „netball“. Иако компанијата подоцна го укинала проектот, случајот покажал колку лесно алгоритмите можат да ја пренесат дискриминацијата од офлајн во онлајн светот. Глобалните статистики покажуваат дека жените се сериозно недоволно застапени во СТЕМ полињата (наука, технологија, инженерство, математика). Во Европската Унија, само околу 17% од ИКТ професионалците се жени. Во Македонија, ситуацијата е слична – девојчињата поретко избираат технички факултети, а жените ретко се наоѓаат на раководни позиции во технолошките фирми. Оваа нееднаквост директно влијае на дизајнот на новите технологии: кога жените не се вклучени во процесот, нивните потреби и перспективи се игнорирани. Многу компании тврдат дека нивните АИ алатки се родово неутрални. Но отсуството на родови категории не значи еднаквост. На пример, апликации за следење на плодност, гласовни асистенти и фитнес алатки се дизајнирани врз основа на машкиот организам како „стандард“. Последиците се очигледни – АИ решенија кои не ги земаат предвид биолошките и општествените разлики меѓу родовите водат до маргинализација. Особено ранлива група се трансродовите и небинарни лица. Многу АИ системи ги принудуваат корисниците да изберат „машко“ или „женско“ како родов идентитет, исклучувајќи цела популација на луѓе. Софтвери за препознавање на лице имаат драстично повисоки стапки на грешки при идентификација на лица кои не се вклопуваат во бинарниот родов модел. Ваквите технолошки неуспеси не се само технички проблем, туку и прашања на човечки права. Клучна улога во справувањето со алгоритамската пристрасност има образованието. Вклучувањето на родовата перспектива во ИКТ програмите уште од средно образование може да ја смени перцепцијата на девојчињата за технологијата како „машка“ професија. Исто така, потребна е едукација на сите ИКТ професионалци во однос на родова чувствителност и анализа на податоци. Неколку земји веќе преземаат мерки за етичка контрола на вештачката интелигенција. ЕУ, преку својот предлог за Закон за вештачка интелигенција, инсистира на транспарентност, следливост и човеков надзор над АИ системите. Во овие политики, важно е да се вклучат и родовите аспекти, со цел да се спречат дискриминаторни ефекти уште во дизајн-фазата. Потребно е зголемена застапеност на жени во технолошките индустрии и истражувачки тимови, обука за родова анализа при развој и тестирање на АИ системи, користење разновидни и репрезентативни бази на податоци, консултација со родови експерти и активисти, како и финансиска и институционална поддршка за родова инклузија во СТЕМ образованието.

Етичка и инклузивна дигитална иднина: АИ како алатка за еднаквост, а не за дискриминација

АИ има потенцијал да го подобри животот на милиони луѓе. Но, без критичка анализа и свесност за социјалниот контекст во кој се развива, таа може да придонесе за уште подлабоки форми на дискриминација. Алгоритмите не се независни – тие се огледало на општеството. Затоа, клучно е технологијата да се развива со одговорност, инклузивност и праведност. Само така ќе изградиме дигитална иднина во која сите родови ќе бидат еднакво вреднувани. Дополнително, важно е да се развие национална стратегија која ќе ја поврзе дигиталната трансформација со принципите на еднаквост и инклузија. Владите треба да инвестираат не само во технолошки напредок, туку и во создавање на политики кои ќе обезбедат правичен пристап до новите технологии. Ова вклучува пристап до интернет, опрема и дигитална едукација за ранливите групи, особено жените од рурални средини, припадничките на етнички малцинства и жените со попреченост. Дигиталната нееднаквост станува нова форма на социјална исклученост, која дополнително ги зајакнува веќе постоечките разлики во можностите за вработување, образование и учество во јавниот живот. Не смее да се заборави ниту улогата на медиумите и јавниот дискурс во обликувањето на општественото разбирање за АИ и родот. Начинот на кој медиумите известуваат за технолошкиот развој често ги игнорира или маргинализира родовите прашања. Прикажувањето на АИ како машка територија ја нормализира исклученоста на жените и го одвраќа интересот на девојчињата за технолошки професии. Потребно е промовирање на позитивни примери и улоги, како и вклучување на женски гласови во јавната дебата за технологија. Академските институции, невладините организации и медиумите треба заеднички да работат на создавање на нов наратив кој ги прифаќа различностите и ги афирмира придонесите на жените во технолошкиот развој. Истовремено, потребна е промена и во самите технолошки компании. Преку воведување на интерни етички регулативи, транспарентност во процесите на дизајн и тестирање, како и вклучување на родова перспектива во секој чекор од развојот, компаниите можат да придонесат кон поправедна технолошка иднина. Не станува збор само за технички прашања – станува збор за вредности, одговорност и визија за општество во кое секој поединец има еднакви можности. Компаниите имаат обврска да се оттргнат од пристапот „прво технологија, потоа етика“, и да започнат со модели на развој кои вклучуваат мултидисциплинарен пристап, со соработка меѓу инженери, социолози, правници и експерти за род. Понатаму, важно е да се размислува долгорочно. Развојот на вештачката интелигенција не смее да се води само од пазарните интереси и иновацискиот ентузијазам, туку и од етичките императиви и потребата за општествена одговорност. Институциите од јавниот и приватниот сектор треба да вложат напори за континуирана проценка на влијанието на нивните технолошки решенија врз различните општествени групи, а особено врз жените и маргинализираните заедници. Исто така, мора да се воспостават независни надзорни тела кои ќе имаат мандат да ја следат транспарентноста и инклузивноста на алгоритмите. Во контекст на националната и глобалната соработка, потребна е координација меѓу државите за воспоставување заеднички етички стандарди, со цел да се спречи технолошки неоколонијализам кој ги изостава помалку развиените и ранливите заедници.

Улогата на младите генерации и глобалните актери

Ништо од ова нема да биде можно без културна промена. Односот кон АИ треба да се трансформира од неутрален во критички, инклузивен и рефлексивен. Треба да се поддржува развој на технологии кои го почитуваат човековото достоинство и кои активно придонесуваат за намалување на нееднаквостите. Токму затоа, улогата на младите генерации, особено студентите од родови студии, ИКТ и општествени науки, е пресудна. Тие се тие што ќе треба да осмислат, создадат и применат нова парадигма за однос меѓу човекот и технологијата. Оваа парадигма мора да биде заснована на праведност, еднаквост и човечност. Дополнително, треба да се разгледа улогата на меѓународните организации и глобалните дигитални платформи, кои имаат моќ да поставуваат стандарди што го обликуваат развојот на технологијата ширум светот. Организации како UNESCO, UN Women и European Commission имаат обврска да го интегрираат родовиот пристап не само како декларативен принцип, туку како конкретна методологија што ќе биде присутна при секоја фаза од креирање на технолошките решенија. Потребно е финансирање на истражувања што ќе го следат родовото влијание на вештачката интелигенција во различни контексти: урбани и рурални средини, развиени и неразвиени земји, млади и постари генерации. Исто така, потребно е внимателно да се анализира концептот на „родово интелигентна технологија“. Ова не е само технологија што не дискриминира, туку и технологија што активно придонесува за трансформација на родовите односи. Пример за тоа се платформи што овозможуваат економска независност на жени преку дигитална работа, апликации што ги поддржуваат жртвите на семејно насилство или образовни софтвери што охрабруваат девојчиња да влезат во СТЕМ. Овие иницијативи треба да се поддржат, но и критички да се проценат нивните резултати.

Родови аспекти на Балканот

Во контекст на Балканот, иако употребата на напредни системи со вештачка интелигенција е сè уште во развој, веќе се забележуваат индиректни последици од дигиталната трансформација врз родовата еднаквост. На пример, неколку платформи за вработување што се користат во Србија, Босна и Херцеговина и Македонија користат автоматски системи за селектирање кандидати кои, иако не се базирани на напредна АИ, функционираат врз основа на шеми на пребарување и машинско учење. Истражувања покажале дека жените, особено мајките, имаат значително помала видливост во тие системи поради начинот на кој се моделираат клучните зборови и професионалните профили. Во Северна Македонија, беше забележан случај кога автоматизираниот систем за распределба на пациенти во еден јавен здравствен дом ги селектираше жените за одредени, „поемпатични“ здравствени професии – како педијатрија – а мажите за хирургија. Иако системот не беше формално базиран на вештачка интелигенција, тој го користеше историскиот распоред на кадар, што индиректно ја одржуваше родовата сегрегација во медицинските професии. Во Хрватска, неколку јавни институции започнаа пилот-програми за дигитална едукација во рурални средини. Програмите покажаа дека девојчињата имаат помал пристап до компјутери и интернет, што ја ограничува нивната вклученост во дигитални и СТЕМ активности. Овој вид на структурна дигитална нееднаквост, ако се занемари, ќе продолжи да продуцира генерациски јаз помеѓу половите во технолошкиот сектор. Во Албанија, една локална банка која воведе автоматизирана услуга за скрининг на биографии забележала несразмерно ниско рангирање на кандидатки од помали градови. Причината била тоа што алгоритмот ги рангирал институциите за образование според нивната репутација во базата на податоци – а многу жени од рурални области се школувале во образовни установи што не биле препознаени од системот. Ова е индиректна дискриминација што ја ограничува нивната економска мобилност. Во Бугарија, беа спроведени неколку истражувања во рамки на дигиталната стратегија на министерството за образование, кои покажале дека девојчињата поретко се охрабруваат да изберат предмети поврзани со информатика и математика, особено кога наставните материјали и системи за онлајн учење не прикажуваат родово разновидни примери. Визуелизацијата на „технолошки успех“ често претставува машки фигури, што психолошки ги одвраќа ученичките. Во Црна Гора, при анализа на интернет-платформи за огласување работни позиции, е откриено дека жените поретко ги гледаат огласите за позиции во ИКТ, инженерство и финтек. Причината лежи во алгоритмите на платформите што креираат „персонализирана содржина“ врз основа на претходни пребарувања и родово кодирано однесување. Наместо да ги прошируваат хоризонтите, тие алгоритми ги ограничуваат. Во Косово, при развој на дигитални платформи за е-управување и пристап до јавни услуги, е утврдено дека постои значителен јаз меѓу половите во користењето на е-владините услуги. Жените поретко се пријавуваат или креираат дигитални идентитети, делумно поради недоверба, но и поради сложеноста на платформите кои не се дизајнирани со инклузивност на ум. Ова води до исклучување на жени од административни процеси и учество во демократскиот живот. Овие примери покажуваат дека иако Балканот не е водечки регион во примената на вештачка интелигенција, постојат суптилни начини на кои постоечките дигитални системи – дури и оние кои се претставуваат како „родово неутрални“ – всушност ја репродуцираат и засилуваат нееднаквоста. Затоа е важно креирањето на дигитални стратегии и технологии да биде свесно втемелено во принципите на родова еднаквост уште од почеток.

Родови проблеми во АИ системите на развиените земји

Во Обединетото Кралство, студија на University of Cambridge покажа дека алгоритмите што се користат од страна на компаниите за кредитирање автоматски им доделуваат пониски кредитни рејтинзи на жените. Причината не била директна дискриминација, туку индиректна – жените почесто користат краткорочни заеми или имаат непостојани примања поради породилни отсуства, што алгоритмот го препознава како „ризично“. Во Франција, едно истражување спроведено врз систем за автоматизирано препознавање говор откри дека софтверот има потешкотии при разбирање на женски гласови, особено оние со регионален акцент. Ова предизвикува недоволна функционалност на јавните услуги базирани на глас, како што се телефонските линии за здравствена поддршка, каде жените претставуваат значителен процент од корисниците. Во Германија, неколку јавни институции користеа АИ за распределба на ресурси за интеграција на бегалци. Анализите покажаа дека женските барателки на азил поретко добивале понуди за стручни обуки и курсеви, бидејќи алгоритмот бил обучен врз историски податоци кои одразувале традиционални улоги (како грижа за домот) и ниска активност на жените на пазарот на труд. Во Шведска, и покрај високото ниво на родова еднаквост, експертите открија дека системите за машинско учење користени од болници за предвидување на ризици кај пациенти не правеле доволна разлика меѓу мажи и жени во врска со симптомите на срцев удар. Ова резултирало со подценување на ризикот кај жените, бидејќи податоците со кои бил трениран системот главно доаѓале од машки пациенти. Овие примери покажуваат дека дури и во развиени демократии, вештачката интелигенција може несвесно да ги продлабочи постојните родови нееднаквости, ако не се применуваат социјално свесни практики при дизајнот и примената.

Предизвици за праведна вештачка интелигенција

Една важна димензија што не смее да се изостави во разговорот за вештачката интелигенција (АИ) и родот е интерсекционалноста – концепт што го признава преклопувањето на повеќе идентитети и начини на потиснување. Жените не се хомогена група, и родовата дискриминација ретко делува изолирано. На пример, црните жени, жените со попреченост, мигрантките и припадничките на ЛГБТИ+ заедницата често се соочуваат со повеќекратна маргинализација. Алгоритмите кои не ја земаат предвид оваа комплексност можат дополнително да ги исклучат овие групи. Истражувањата на Joy Buolamwini, основачка на Algorithmic Justice League, покажаа дека софтверите за препознавање на лице имале највисока точност кај бели мажи, а најниска кај црни жени – разлика што директно го покажува недостатокот на репрезентативност во тренинг податоците и потребата од етички осмислено програмирање. Прашањето за транспарентноста и објаснивоста на АИ системите станува клучно кога се анализира нивното влијание врз родовата еднаквост. Повеќето алгоритми, особено оние базирани на машинско учење, функционираат како „црни кутии“, што значи дека дури и креаторите не можат секогаш да објаснат зошто системот донел одредена одлука. Во контекст на родот, ова може да доведе до ситуации каде жените или небинарните лица се дискриминирани без можност за жалба или корекција. Затоа е потребно да се инсистира на објасниви АИ модели (explainable AI – XAI) кои овозможуваат увид и контрола од страна на корисниците и засегнатите страни. Покрај тоа, културниот контекст игра голема улога во тоа како се развива и применува АИ. Во патријархални општества каде родовите стереотипи се длабоко вкоренети, постои реален ризик тие културни вредности да се вградат во самите алгоритми. На пример, во одредени земји, системи за предвидување на успех кај ученици автоматски им доделуваат повисоки оценки на машки ученици во предмети како математика и физика, врз основа на историски податоци. Таквите примери покажуваат дека културната пристрасност не е неутрална и дека нејзината дигитализација ја репродуцира и институционализира дискриминацијата.

Кон праведна и безбедна дигитална иднина

Од аспект на јавното здравство, АИ има потенцијал да го трансформира начинот на дијагноза и третман. Но, ако системите се обучени врз податоци добиени главно од машки пациенти, жените остануваат невидливи во медицинските анализи. Симптомите на срцев удар, на пример, често се различни кај жените, но многу АИ системи не се обучени да ги препознаваат тие варијации. Ова не е само технички пропуст, туку и прашање на живот и смрт. Истото важи и за репродуктивното здравје, каде апликациите за следење на циклусот често не се доволно прецизни или приватни, оставајќи ги корисничките изложени на ризик. Во образованието, потенцијалот на АИ да ја персонализира наставата може да се искористи за намалување на родовиот јаз, но само ако е дизајнирана со родова чувствителност. Ако, пак, системите автоматски ги насочуваат девојчињата кон „традиционални“ женски професии, како медицински сестри или учителки, додека момчињата ги фаворизираат за информатика или инженерство, тогаш образованието станува средство за репродукција на статус кво. Важно е да се спомене и улогата на корпоративната одговорност. Технолошките компании имаат моќ да влијаат врз дизајнот на иднината – но со таа моќ доаѓа и обврска. Компаниите како Microsoft и IBM започнаа да објавуваат „AI Ethics Guidelines“ кои вклучуваат принципи како правичност, отчетност и недискриминација. Но овие напори често остануваат на декларативно ниво, без реална имплементација или независен надзор. Потребно е да се формираат надворешни тела – составени од експерти за род, етика и технологија – кои ќе ја следат имплементацијата на овие стандарди и ќе интервенираат кога ќе се детектираат проблеми. Истовремено, жените и маргинализираните групи треба да имаат поголем пристап до средствата и просторот за развој на сопствени технолошки решенија. Во последниве години се појавуваат иницијативи како „feminist AI“ или „queer AI“, кои претставуваат алтернативни пристапи кон дизајнот и употребата на алгоритми, втемелени врз вредности на инклузија, емпатија и правичност. Овие пристапи ја прошируваат дефиницијата на технологија – не како неутрален алат, туку како културен и политички артефакт. Потребно е исто така да се охрабрат жените и небинарните лица да учествуваат во технологијата не само како корисници, туку и како креатори. Хакатони, стипендии, менторски програми и инкубатори насочени кон родова рамноправност можат да помогнат во надминување на бариерите. Успешни примери веќе постојат – организации како „Girls Who Code“, „Black in AI“ и „Women in Machine Learning“ придонесуваат за видливост и застапеност. Исто така, мора да се преиспита концептот на „неутрална технологија“. Самото избегнување на спомнување род, како што често се прави со цел да се избегне дискриминација, всушност доведува до невидливост. Вистинската инклузија не се постигнува со игнорирање на разликите, туку со нивно препознавање и уважување. Тоа значи дека алгоритмите треба свесно да бидат дизајнирани така што ќе ги земат предвид различните искуства, потреби и идентитети. Важно е да се разгледа како вештачката интелигенција влијае врз политичкото учество и застапеноста на жените. Во дигиталната ера, многу кампањи се водат преку социјалните медиуми, каде алгоритмите играат клучна улога во тоа кој ќе ја види која содржина. Истражувања покажуваат дека женските политичарки и активистки се почесто цел на онлајн малтретирање и дискредитација – феномен што алгоритмите не го препознаваат како проблем или, дури и полошо, го засилуваат преку ангажман-базирани препораки. Ова ја намалува видливоста и влијанието на женските гласови во јавната сфера. Алгоритмите кои не можат да препознаат родово базирана злоупотреба придонесуваат за културна тишина и дигитален сексизам. Истовремено, постои сериозна празнина во истражувањето на локалниот контекст – односно како македонските дигитални платформи и владини системи ја третираат родовата еднаквост при интеграцијата на АИ. Во јавните набавки, ретко се бара родова анализа на дигиталните решенија што се воведуваат. Многу државни системи се креирани од приватни технолошки фирми кои немаат обврска да следат родови етички стандарди. Тука постои ризик државните институции несвесно да усвојат технолошки алатки кои репродуцираат дискриминаторни модели. Потребно е државата да воспостави јасни критериуми за етичка и родово одговорна технологија како дел од секој тендер или партнерство. Уште еден значаен аспект што вреди да се вклучи е влијанието на генеративните АИ модели како ChatGPT, DALL·E, Midjourney и други врз родовите перцепции. Овие системи често произведуваат содржина што рефлектира и зацврстува постоечки родови стереотипи. На пример, ако од еден таков модел побарате „слика на инженер“, голема е веројатноста да добиете претежно машки фигури, ако побарате „учителка“, ќе се појават жени. Иако овие резултати се технички „неконфликтни“, тие имаат длабоко општествено влијание – особено врз младите кои ја користат технологијата секојдневно и се во фаза на градење на сопствениот идентитет. Родово чувствителниот дизајн на овие системи мора да стане приоритет. Родовата анализа мора да се прошири и на прашањата поврзани со приватноста и надзорот. Жените и маргинализираните групи се почесто предмет на алгоритамски надзор, особено во авторитарни режими. На пример, АИ системи за препознавање на лице се користат за следење на активистки и демонстрантки, што претставува закана за правото на приватност и безбедност. Во контексти каде жените се жртви на семејно насилство, овие технологии можат да бидат двосек меч – ако не се користат со соодветна етичка регулација, тие можат да бидат злоупотребени од страна на насилниците или институциите. Неопходно е и родово освестено планирање на идни технолошки иновации, особено оние кои вклучуваат автономни системи, како самоуправувачки возила, паметни домови, медицински роботи и слично. При нивниот развој, мора да се вклучат прашања како: кој има пристап до овие технологии, кој е застапен во тестирањето, како се моделираат грижата, безбедноста и довербата? Во многу случаи, жените се оние што се грижат за деца, стари и болни – и нивниот глас мора да биде присутен во фазата на концепција, не само во фазата на употреба. Академската заедница треба активно да ја унапредува интердисциплинарноста. Прашањата за родот и технологијата не треба да бидат изолирани во одделни предмети или изборни програми. Тие треба да се интегрираат во основните курикулуми на компјутерските науки, инженерството, економијата и правото. Така студентите од различни области ќе бидат свесни за родовите импликации на нивната работа и ќе можат критички да ги анализираат сопствените решенија уште од самиот почеток.

Завршни размислувања: Заедничка одговорност за родово праведна технологија

Во крајна линија, иднината на вештачката интелигенција зависи од тоа какви вредности ќе ѝ вградиме денес. Ако не го сториме тоа свесно и одговорно, ризикуваме да создадеме дигитален свет што ќе биде само ново лице на старите неправди. Ако, пак, вложиме труд и критичка свест, можеме да изградиме технологии што навистина ќе служат за доброто на сите луѓе – независно од нивниот пол, родов идентитет или општествен статус. На крајот, треба да се нагласи дека борбата против алгоритамската дискриминација не е само техничка задача. Таа е дел од пошироката борба за социјална правда и еднаквост. Секоја анализа, секој софтвер, секој систем што се имплементира мора да биде подложен на прашањето: кого го исклучуваме, кого го забораваме и како можеме да создадеме технологии што навистина служат на сите. Во тој контекст, улогата на образованието, политиката и граѓанското општество е незаменлива. Само преку заеднички напори ќе може да се спречи повторното создавање на дигитална нееднаквост врз база на род. Притоа, секој чекор што ќе го направиме кон повеќе вклученост, ќе биде чекор кон праведно и еднакво дигитално општество за сите.

Библиографија:

- Buolamwini, J. & Gebru, T. (2018). “Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification.” Proceedings of Machine Learning Research.

- Criado Perez, C. (2019). Invisible Women: Exposing Data Bias in a World Designed for Men. Abrams Press.

- UNESCO (2020). “Artificial Intelligence and Gender Equality.”

https://unesdoc.unesco.org/ark:/48223/pf0000374174 - European Commission (2021). Proposal for a Regulation on Artificial Intelligence.

https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A52021PC0206 - EIGE (2023). “Gender Equality and Digitalisation in the EU.”

https://eige.europa.eu/publications/gender-equality-and-digitalisation - Higgins, A. (2021). “AI and Ethics: The New Frontier of Gender Inclusion.” Journal of Ethics in Technology.

- AI Gender Platform. https://platforma.aigender.net/

- Wajcman, J. (2004). TechnoFeminism. Polity Press.

- D’Ignazio, C. & Klein, L.F. (2020). Data Feminism. MIT Press.

- Noble, S.U. (2018). Algorithms of Oppression: How Search Engines Reinforce Racism. NYU Press.

- Algorithmic Justice League. https://www.ajlunited.org/

- Women in Machine Learning. https://wimlworkshop.org/

- Girls Who Code. https://girlswhocode.com/

- Black in AI. https://blackinai.org/

- European Institute for Gender Equality (2022). “Gender Mainstreaming in AI and Big Data.”